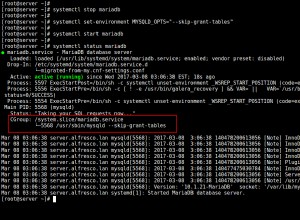

Musiałem dodać driver opcja podczas korzystania z sparkSession read funkcjonować.

.option("driver", "org.postgresql.Driver")

var jdbcDF - sparkSession.read

.option("driver", "org.postgresql.Driver")

.option("url", "jdbc:postgresql://<host>:<port>/<DBName>")

.option("dbtable", "<tableName>")

.option("user", "<user>")

.option("password", "<password>")

.load()

W zależności od tego, jak skonfigurowane są twoje zależności, zauważysz, że gdy dołączysz coś takiego jak compile group: 'org.postgresql', name: 'postgresql', version: '42.2.8' na przykład w Gradle będzie to obejmować klasę Driver w org/postgresql/Driver.class , i to jest ten, który chcesz załadować Sparka.