W tym samouczku Hadoop omówimy 10 najlepszych funkcji Hadoop. Jeśli nie znasz Apache Hadoop, możesz zapoznać się z naszym Wprowadzeniem Hadoop blog, aby uzyskać szczegółową wiedzę na temat frameworka Apache Hadoop.

W tym blogu omówimy najważniejsze funkcje Big Data Hadoop, takie jak Hadoop Fault Tolerance, Distributed Processing w Hadoop, Skalowalność, Niezawodność, Wysoka dostępność, ekonomiczność, elastyczność, lokalizacja danych w Hadoop.

Wprowadzenie Hadoop

Hadoop to platforma oprogramowania typu open source, która obsługuje rozproszone przechowywanie i przetwarzanie ogromnej ilości zestawu danych. Jest to najpotężniejsze narzędzie Big Data na rynku ze względu na swoje funkcje. Funkcje takie jak odporność na awarie, niezawodność, wysoka dostępność itp.

Hadoop zapewnia-

- HDFS – Najbardziej niezawodna na świecie warstwa do przechowywania

- MapReduce – Rozproszona warstwa przetwarzania

- PRZĘDZA – Warstwa zarządzania zasobami

Ważne funkcje Big Data Hadoop

Apache Hadoop zapewnia tak wiele funkcji. Omówmy szczegółowo te funkcje Hadoop.

a. Otwórz źródło

Jest to platforma programistyczna o otwartym kodzie źródłowym oparta na Javie. Open source oznacza, że jest dostępny bezpłatnie, a nawet możemy zmienić jego kod źródłowy zgodnie z Twoimi wymaganiami.

b. Tolerancja błędów

Błędy kontroli Hadoop w procesie tworzenia repliki. Gdy klient przechowuje plik w HDFS, platforma Hadoop dzieli plik na bloki. Następnie klient dystrybuuje bloki danych na różne maszyny obecne w klastrze HDFS.

A następnie utwórz replikę każdego bloku na innych komputerach obecnych w klastrze. HDFS domyślnie tworzy 3 kopie bloku na innych maszynach obecnych w klastrze.

Jeśli jakakolwiek maszyna w klastrze przestanie działać lub ulegnie awarii z powodu niesprzyjających warunków. Wtedy również użytkownik może łatwo uzyskać dostęp do tych danych z innych komputerów.

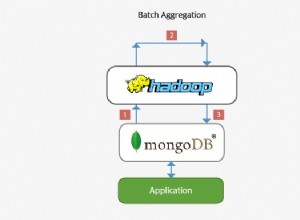

c. Przetwarzanie rozproszone

Hadoop przechowuje ogromne ilości danych w sposób rozproszony w HDFS. Przetwarzaj dane równolegle w klastrze węzłów.

d. Skalowalność

Hadoop to platforma typu open source. To sprawia, że jest to niezwykle skalowalna platforma. Dzięki temu nowe węzły można łatwo dodawać bez przestojów. Hadoop zapewnia skalowalność poziomą, dzięki czemu nowy węzeł jest dodawany w locie do systemu. W Apache hadoop aplikacje działają na ponad tysiącach węzłów.

e. Niezawodność

Dane są niezawodnie przechowywane w klastrze maszyn pomimo awarii maszyny spowodowanej replikacją danych. Tak więc, jeśli któryś z węzłów ulegnie awarii, możemy również niezawodnie przechowywać dane.

f. Wysoka dostępność

Dzięki wielu kopiom danych dane są wysoce dostępne i dostępne pomimo awarii sprzętu. Tak więc każda maszyna ulegnie awarii, dane można pobrać z innej ścieżki. Dowiedz się szczegółowo o funkcji wysokiej dostępności Hadoop.

g. Ekonomiczny

Hadoop nie jest bardzo drogi, ponieważ działa na klastrze sprzętu powszechnego. Ponieważ używamy niedrogiego, standardowego sprzętu, nie musimy wydawać ogromnych pieniędzy na skalowanie Twojego klastra Hadoop.

ja. Elastyczność

Hadoop jest bardzo elastyczny pod względem możliwości radzenia sobie z wszelkiego rodzaju danymi. Zajmuje się strukturalnym, półstrukturalnym lub niestrukturalnym.

j. Łatwy w użyciu

Nie ma potrzeby, aby klient zajmował się przetwarzaniem rozproszonym, framework zajmuje się wszystkimi rzeczami. Dzięki temu jest łatwy w użyciu.

k. Lokalizacja danych

Odnosi się do możliwości przeniesienia obliczeń blisko miejsca, w którym znajdują się rzeczywiste dane w węźle. Zamiast przenosić dane do obliczeń. Minimalizuje to przeciążenie sieci i zwiększa przepustowość systemu. Dowiedz się więcej oLokalizacja danych.

Wniosek

Podsumowując, możemy powiedzieć, że Hadoop jest wysoce odporny na błędy. Niezawodnie przechowuje ogromne ilości danych pomimo awarii sprzętu. Zapewnia wysoką skalowalność i wysoką dostępność.

Hadoop jest ekonomiczny, ponieważ działa na klastrze zwykłego sprzętu. Hadoop pracuje nad lokalizacją danych, ponieważ przenoszenie obliczeń jest tańsze niż przenoszenie danych. Wszystkie te cechy Big Data Hadoop sprawiają, że jest on potężny w przetwarzaniu Big Data.