To, że organizacje mierzą się z wyzwaniami Big Data, jest w dzisiejszych czasach powszechny. Termin Big Data odnosi się do zestawu wielu technologii, zarówno starych, jak i nowych, w celu wydobycia znaczących informacji z ogromnego stosu danych. Zbiór danych jest nie tylko duży, ale ma również swój własny, unikalny zestaw wyzwań związanych z ich przechwytywaniem, zarządzaniem i przetwarzaniem. W przeciwieństwie do danych utrwalonych w relacyjnych bazach danych, które są ustrukturyzowane, format dużych zbiorów danych może być ustrukturyzowany, częściowo ustrukturyzowany lub nieustrukturyzowany lub zebrany z różnych źródeł o różnych rozmiarach. Ten artykuł zagłębia się w podstawowe aspekty Big Data, ich podstawowe cechy i daje wskazówkę na temat narzędzi i technik używanych do radzenia sobie z nimi.

Przegląd

Termin Big Data sprawia wrażenie tylko wielkości danych. W pewnym sensie to prawda, ale nie daje pełnego obrazu. Wyzwania z tym związane to nie tylko sam rozmiar. W rzeczywistości pomysł ewoluował, aby nazwać morze danych zebranych z różnych źródeł, formatów i rozmiarów, a jednocześnie trudnych do wykorzystania lub uzyskania z nich wartości. Wzrost liczby wschodzących technologii i rosnące wykorzystanie Internetu dały impuls do wzrostu liczby i dysproporcji. Wolumen rośnie wraz z każdą wymianą informacji przez Internet, a nawet przy użyciu maleńkich obiektów IoT, z których korzystamy. Proste odebranie połączenia telefonicznego lub włączenie telewizji przemysłowej może wygenerować łańcuch danych. Obecnie większość urządzeń jest połączona online. Teraz, jeśli organizacja chce zbierać te informacje online, potrzebuje specjalnego procesu przetwarzania, ponieważ generowane dane będą ogromne. Ponadto może nie być jednolitości formatu przechwyconych danych. To zwiększa złożoność, ponieważ mamy do czynienia z danymi ustrukturyzowanymi, częściowo ustrukturyzowanymi lub nieustrukturyzowanymi. Narzędzia, których używaliśmy do tej pory do porządkowania danych, nie są w stanie poradzić sobie z taką różnorodnością i objętością. Dlatego możemy powiedzieć, że termin Big Data w rzeczywistości dotyczy danych, których nie można przetworzyć ani przeanalizować za pomocą tradycyjnych narzędzi i technik, które są zwykle używane do przetwarzania danych ustrukturyzowanych lub częściowo ustrukturyzowanych, takich jak korzystanie z relacyjnych baz danych, XML i tak dalej.

Dzisiejsze organizacje są pełne nieustrukturyzowanych lub częściowo ustrukturyzowanych danych dostępnych w nieprzetworzonym formacie. Dane te mogą stanowić bogactwo informacji, jeśli zostaną przetworzone i uzyskają z nich wartość. Ale problem polega na tym, jak to zrobić. Tradycyjne techniki i narzędzia, takie jak relacyjne bazy danych, nie są w stanie poradzić sobie z tak dużą ilością zróżnicowanych danych. Jest to również problem obosieczny dla organizacji, ponieważ samo ich zniszczenie oznaczałoby utratę cennych informacji – jeśli w ogóle – a ich przechowywanie jest marnowaniem zasobów. W związku z tym poszukuje się narzędzi i technik radzenia sobie z tym problemem. Czasami jesteśmy całkiem pewni, że jego potencjalna wartość leży w stosie i możemy czerpać z tego kopalnię informacji, ale bez odpowiednich narzędzi czerpanie z tego korzyści dla procesu biznesowego jest dość obciążające. Dzisiejsze dane są ogromne i eksplodowały jak wszystko w ostatnich latach; nawiasem mówiąc, wydaje się, że nie da się tego powstrzymać.

Wybuch informacji

Duże zbiory danych stają się coraz większe z każdą minutą w prawie każdym sektorze, czy to w technologii, mediach, handlu detalicznym, usługach finansowych, podróżach i mediach społecznościowych, żeby wymienić tylko kilka. Wielkość przetwarzania danych, o której mówimy, jest oszałamiająca. Oto kilka informacji statystycznych, które pomogą Ci zrozumieć:

- Kanały pogodowe otrzymują 18 055 555 żądań prognozy co minutę.

- Użytkownicy Netflix przesyłają strumieniowo 97 222 godzin wideo co minutę.

- Użytkownicy Skype'a wykonują 176 220 połączeń co minutę.

- Użytkownicy Instagrama publikują 49 380 zdjęć co minutę.

Liczby te rosną z roku na rok, wraz z rosnącą liczbą osób korzystających z Internetu. W 2017 roku korzystanie z Internetu osiągnęło nawet 47% (3,8 miliarda ludzi) światowej populacji. Przy stale rosnącej liczbie urządzeń elektronicznych nasze przybliżone dane wyjściowe szacuje się na 2,5 trylionów bajtów dziennie i rosną.

Statystyki wyszukiwarki Google pokazują 3,5 miliarda wyszukiwań dziennie, czyli średnio ponad 40 000 wyszukiwań na sekundę. Nie powinniśmy również przegapić tego, że inne wyszukiwarki również przeprowadzają wyszukiwania. Raport statystyk poczty e-mail 2015-2019 firmy Radicati Group, Inc. pokazuje 2,9 miliarda użytkowników poczty e-mail do 2019 r.

Próbując oszacować, ile zdjęć zostanie zrobionych w 2017 roku:Jeśli w 2017 roku na świecie było 7,5 miliarda ludzi, a około 5 miliardów miało telefony komórkowe, można przypuszczać, że 80% tych telefonów ma wbudowane aparaty fotograficzne. Oznacza to, że około 4 miliardów ludzi używa swoich kamer. Jeśli robią 10 zdjęć dziennie, co daje 3650 zdjęć rocznie na osobę, daje to około 14 bilionów zdjęć rocznie.

Dlatego, kiedy mówimy o Big Data, zasadniczo odnosi się to do danych lub zestawów rekordów, które są zbyt duże, aby można je było przypuszczać. Są one tworzone za pośrednictwem wyszukiwarek, informatyki biznesowej, sieci społecznościowych, mediów społecznościowych, genomiki, meteorologii, prognoz pogody i wielu innych źródeł. To oczywiście nie może być obsługiwane przy użyciu istniejących narzędzi i technik zarządzania bazami danych. Big Data otwiera arenę wielkich wyzwań w zakresie przechowywania, przechwytywania, zarządzania, konserwacji, analizy, badań, nowych narzędzi do ich obsługi i tym podobnych.

Charakterystyka Big Data

Podobnie jak w przypadku wszystkich wielkich rzeczy, jeśli chcemy nimi zarządzać, musimy je scharakteryzować, aby uporządkować nasze rozumienie. Dlatego Big Data można zdefiniować za pomocą jednej lub więcej z trzech cech, trzech V:wysoki objętość , wysoka różnorodność i wysoka prędkość . Cechy te rodzą kilka ważnych pytań, które nie tylko pomagają nam je rozszyfrować, ale także dają wgląd w to, jak radzić sobie z ogromnymi, rozbieżnymi danymi z rozsądną prędkością w rozsądnym czasie, abyśmy mogli uzyskać z tego wartość. analiza w czasie rzeczywistym i szybka odpowiedź.

- Głośność: Objętość odnosi się do samej wielkości stale eksplodujących danych w świecie komputerów. Rodzi to pytanie o ilość danych.

- Prędkość: Prędkość odnosi się do szybkości przetwarzania. Rodzi to pytanie, z jaką prędkością przetwarzane są dane.

- Odmiana: Różnorodność odnosi się do rodzajów danych. Rodzi to pytanie, jak różne są formaty danych.

Zauważ, że dzielimy Big Data na trzy V, tylko po to, by uprościć jego podstawowe założenia. Jest całkiem możliwe, że rozmiar może być stosunkowo mały, ale zbyt zróżnicowany i złożony, lub może to być stosunkowo prosty, ale ogromny wolumen danych. Dlatego oprócz tych trzech V możemy z łatwością dodać kolejną, Veracity . Veracity określa dokładność danych w stosunku do wartości biznesowej, którą chcemy wydobyć. Bez prawdziwości niemożliwe jest, aby organizacja wykorzystała swoje zasoby do analizy stosu danych. Im większa dokładność co do kontekstu danych, tym większa szansa na uzyskanie cennych informacji. Dlatego też prawdziwość jest kolejną cechą Big Data. Firmy wykorzystują ustrukturyzowane, częściowo ustrukturyzowane i nieustrukturyzowane dane z poczty e-mail, mediów społecznościowych, strumieni tekstowych i nie tylko. Ale przed analizą ważne jest, aby określić ilość i rodzaje danych, które mają wpływ na wyniki biznesowe.

Narzędzia i techniki

Sztuczna inteligencja (AI), IoT i media społecznościowe napędzają złożoność danych dzięki nowym formom i źródłom. Na przykład ważne jest, aby w czasie rzeczywistym duże dane przechodzące przez czujniki, urządzenia, sieci, transakcje były przechwytywane, zarządzane i przetwarzane z małym opóźnieniem. Big Data umożliwia analitykom, badaczom i użytkownikom biznesowym szybsze podejmowanie bardziej świadomych decyzji przy użyciu danych historycznych, które w innym przypadku byłyby nieosiągalne. Można użyć analizy tekstu, uczenia maszynowego, analiz predykcyjnych, eksploracji danych i przetwarzania języka naturalnego, aby wydobyć nowy wgląd z dostępnego stosu danych.

Technologia ewoluowała, aby zarządzać ogromnymi ilościami danych, które wcześniej były drogie i wymagały pomocy superkomputerów. Wraz z pojawieniem się mediów społecznościowych, takich jak Facebook, wyszukiwarek takich jak Google i Yahoo!, projekty Big Data nabrały rozmachu i rosły tak, jak jest dzisiaj. Techniki, takie jak MapReduce, Hadoop i Big Table, zostały opracowane w celu zaspokojenia dzisiejszych potrzeb.

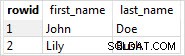

Repozytoria NoSQL są również wspomniane w odniesieniu do Big Data. Jest to alternatywna baza danych w przeciwieństwie do relacyjnych baz danych. Te bazy danych nie organizują rekordów w tabelach wierszy i kolumn, jak w konwencjonalnych relacyjnych bazach danych. Istnieją różne typy baz danych NoSQL, takie jak magazyn treści, magazyn dokumentów, magazyn zdarzeń, wykres, wartość klucza i tym podobne. Nie używają SQL do zapytań i stosują inny model architektoniczny. Okazuje się, że ułatwiają one analizę Big Data w korzystny sposób. Niektóre popularne nazwy to:Hbase, MongoDB, CouchDB i Neo4j. Oprócz nich istnieje wiele innych.

Wniosek

Big Data otworzyła nową szansę na zbieranie danych i wydobywanie z nich wartości, które w przeciwnym razie marnują. Nie da się przechwytywać, zarządzać i przetwarzać Big Data za pomocą tradycyjnych narzędzi, takich jak relacyjne bazy danych. Platforma Big Data zapewnia narzędzia i zasoby do wydobywania wglądu w obszerne, różnorodne i szybkie dane. Te stosy danych mają teraz środki i realny kontekst, które można wykorzystać do różnych celów w procesie biznesowym organizacji. Dlatego, aby dokładnie określić, o jakim typie danych mówimy, musimy zrozumieć je i ich cechy jako podstawowy krok.