Program ochrony wynagrodzeń (PPP) jest wdrażany przez rząd federalny Stanów Zjednoczonych, aby zapewnić bezpośrednią zachętę dla firm do utrzymywania pracowników na liście płac, szczególnie podczas pandemii Covid-19. PPP pomaga wykwalifikowanym firmom zatrzymać ich siłę roboczą, a także pokryć związane z tym wydatki biznesowe. Dane ze strony internetowej Ministerstwa Skarbu USA pokazują, które firmy otrzymały pożyczki PPP i ile miejsc pracy zostało utrzymanych. Departament Skarbu USA zatwierdził około miliona pożyczek PPP w całych Stanach Zjednoczonych.

Analiza tych danych przedstawia trzy wyzwania. Po pierwsze, wielkość danych jest znacząca. Czas potrzebny na pobieranie, selekcjonowanie, przekształcanie, pobieranie i raportowanie tych danych jest czasochłonny. Po drugie, zbiór danych prawdopodobnie będzie ewoluował, co pochłonie dodatkowy czas i zasoby na rozwój. Wreszcie, w wieloetapowym procesie, takim jak ten, istnieje szansa, że coś się zepsuje. Możliwość szybkiego określania błędów lub wąskich gardeł pomoże konsekwentnie spełniać umowy SLA.

Ten blog ilustruje, w jaki sposób Cloudera Data Engineering (CDE), wykorzystujący Apache Spark, może być używany do tworzenia raportów opartych na danych PPP, jednocześnie odpowiadając na każde z opisanych powyżej wyzwań.

Cel

Przykładowy scenariusz dla Texas Legislative Budget Board (LBB) został przedstawiony poniżej, aby pomóc inżynierowi danych zarządzać i analizować dane PPP. Głównym celem inżyniera danych jest dostarczenie LBB dwóch raportów końcowych:

- Raport 1:Podział wszystkich miast w Teksasie, które zachowały miejsca pracy

- Raport 2:Podział typu firmy, która utrzymała miejsca pracy

Inżynieria danych Cloudera (CDE)

Tutaj może pomóc Cloudera Data Engineering (CDE) z systemem Apache Spark. CDE to jedna z usług w Cloudera Data Platform (CDP), która umożliwia inżynierom danych tworzenie, zarządzanie i planowanie zadań Apache Spark, zapewniając jednocześnie przydatne narzędzia do monitorowania wydajności zadań, uzyskiwania dostępu do plików dzienników i organizowania przepływów pracy za pośrednictwem Apache Airflow. Apache Spark to platforma przetwarzania danych, która jest zdolna do szybkiego przetwarzania danych na dużą skalę.

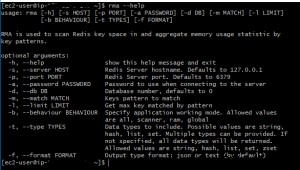

Departament Skarbu USA udostępnia dwa różne zestawy danych, jeden dla zatwierdzonych pożyczek powyżej 150 tys. USD i jeden dla zatwierdzonych pożyczek poniżej 150 tys. Aby stworzyć dwa raporty końcowe dla LBB, wykonano te kroki (patrz rys. 1).

- Pierwszym krokiem było załadowanie dwóch oddzielnych zestawów danych do zasobnika S3.

- Utworzono zadanie Spark dla każdego zestawu danych do pobierania i filtrowania danych z zasobnika S3.

- Te dwa zadania Spark przekształciły i załadowały czyste dane do magazynu danych Hive w celu ich pobrania.

- Trzecie zadanie Spark zostało utworzone w celu przetwarzania danych z magazynu danych Hive w celu utworzenia dwóch raportów.

Po zakończeniu wykonywania zadań CDE dostarczyło graficzną reprezentację różnych etapów w ramach każdego zadania Spark (patrz rys. 2). Umożliwiło to inżynierowi danych łatwe sprawdzenie, które części zadania potencjalnie zajmowały najwięcej czasu, co pozwoliło im łatwo udoskonalić i ulepszyć swój kod, aby jak najlepiej spełnić umowy SLA klientów.

Rys. 1:Podróż danych w celu utworzenia dwóch raportów końcowych.

Rys. 2:Graficzna reprezentacja CDE różnych etapów Sparka.

Wyniki

Osiągnięto główny cel, jakim było sporządzenie dwóch raportów końcowych na podstawie rekordu miliona zatwierdzonych wnioskodawców. Graficzne podsumowanie pierwszego raportu (patrz ryc. 3) pokazuje pierwszą 10 próbkę liczby zachowanych miejsc pracy na miasto w Teksasie, a drugi raport (patrz ryc. 4) pokazuje pierwszą 5 próbkę liczby zachowanych miejsc pracy według typu firmy. Dzięki tym raportom, Texas Legislative Budget Board może na przykład wywnioskować, że miasta z najmniejszym poziomem utrzymania miejsc pracy na mieszkańca mogą potrzebować zasobów, aby zmniejszyć jakikolwiek wpływ ekonomiczny.

Rys. 3:Top 10 miast, które utrzymały najwięcej miejsc pracy, stan Teksas, 2020

Rys. 4:Top 5 typów firm, które utrzymały najwięcej miejsc pracy, stan Teksas, 2020

Dalsze kroki

Aby zobaczyć to wszystko w akcji, kliknij poniższe linki do kilku różnych źródeł prezentujących proces, który został utworzony.

- Wideo – jeśli chcesz zobaczyć i usłyszeć, jak to zostało zbudowane, obejrzyj film pod linkiem.

- Samouczki – jeśli chcesz to zrobić we własnym tempie, zobacz szczegółowy przewodnik ze zrzutami ekranu i instrukcje linia po linii, jak to skonfigurować i wykonać.

- Meetup – Jeśli chcesz porozmawiać bezpośrednio z ekspertami z Cloudera, dołącz do wirtualnego spotkania, aby zobaczyć prezentację na żywo. Na końcu będzie czas na bezpośrednie pytania i odpowiedzi.

- Strona użytkowników CDP – aby dowiedzieć się o innych zasobach CDP stworzonych dla użytkowników, w tym o dodatkowych filmach, samouczkach, blogach i wydarzeniach, kliknij link.