Jedną z głównych obaw administratorów baz danych, którzy muszą rozładowywać duże zbiory danych z tabel bardzo dużych baz danych (VLDB), jest szybkość. Szybsze rozładowywanie sprawia, że dane są dostępne w różnych formach dla różnych celów i platform. Im szybciej dane są pozyskiwane, tym szybciej można je przetwarzać i dostarczać. Ostatecznym rezultatem jest szybszy czas do rozwiązania, a tym samym produktywność i konkurencyjność firm, które zarabiają na informacjach.

Większość dostępnych narzędzi i metod używanych obecnie do wydobywania danych z dużych tabel faktów jest po prostu zbyt wolna. Te, które rzekomo są szybsze, są skomplikowane, zastrzeżone lub wymagają zakupu kosztownego pakietu ETL. Przejście na paradygmat ELT lub Hadoop pociąga za sobą duże wydatki na sprzęt (lub urządzenie DB), opodatkowuje bazową bazę danych, która teraz się przekształca, i nakłada strome krzywe uczenia się i obciążenia związane z utrzymaniem.

Czy nie ma innych opcji rozładowywania i dalszych procesów, które są szybsze, prostsze i bardziej przystępne cenowo?

Dlaczego usuwać tabele VLDB?

Istnieje wiele powodów, dla których warto w pierwszej kolejności zbiorczo wyładować dane z tych tabel:

Migracja bazy danych :im szybciej możesz pobrać dane ze starszych baz danych, tym szybciej możesz zmapować i przenieść dane do nowych baz danych. Masowe przenoszenie danych byłoby korzystne, jeśli wolumeny danych są ogromne, korzystne jest przekształcenie, ochrona i/lub analiza w trybie offline (co jest możliwe jednocześnie w IRI CoSort) oraz gdy wstępnie posortowane ładunki zbiorcze są jedynym sposobem spełnienia Terminy SLA.

Reorganizacja bazy danych :Rozładuj, posortuj, ponownie załaduj, aby baza danych działała wydajnie i zoptymalizuj typowe zapytania, utrzymując tabele w kolejności łączenia. Rozładunek odbywa się w ramach reorganizacji off-line lub zewnętrznych. Zobacz to porównanie metod reorg off-line i on-line.

Integracja danych :Operacje ekstrakcji-transformacji-ładowania na dużą skalę (ETL) rozpoczynają się od ekstrakcji tabel do obszaru przemieszczania danych. Dane zrzucane z tabel i mieszane z zestawami danych na komputerach mainframe, dziennikami sieciowymi i innymi plikami prostymi można najefektywniej integrować i przetwarzać w systemie plików. Zewnętrzne przekształcenia są nie tylko bardziej wydajne, ponieważ wiele działań można przeprowadzić w jednym przebiegu we/wy, ale także dlatego, że narzut obliczeniowy całej tej pracy jest usuwany z bazy danych (patrz ETL vs. ELT).

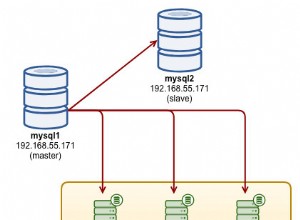

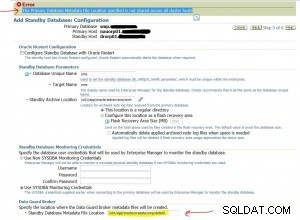

Replikacja/archiwizacja danych :Odciążając tabele faktów, dane operacyjne ze złotego źródła mogą być duplikowane i przechowywane w formacie przenośnym. Dane w płaskich plikach można wyszukiwać, manipulować i ponownie formatować za pomocą narzędzi takich jak IRI NextForm lub CoSort oraz używać do wypełniania innych baz danych i aplikacji. Podobnie dostępne repozytorium tych danych może być również przechowywane w trybie offline w celu przywracania i pobierania kopii zapasowych lub dystrybucji do stron, które wymagają dostępu do danych w innym środowisku.

Analiza biznesowa :Importowanie danych operacyjnych do programu Excel i innych narzędzi BI w formatach plików płaskich, takich jak CSV i XML, może być szybsze i łatwiejsze niż próba łączenia tabeli z arkuszem kalkulacyjnym lub kostką BI. Przenoszenie tabel do płaskich plików jest zatem pierwszym i wydajnym krokiem we franczyzie danych – przygotowaniu danych do operacji BI.

Spojrzenie na metody rozładowywania

Metody ekstrakcji VLDB różnią się wydajnością i funkcjonalnością. Dobre narzędzie do rozładowywania dużych zbiorów danych z Oracle i innych głównych baz danych musi być wydajne, łatwe w użyciu i obsługiwać określone funkcje formatowania, które nie obciążałyby procesu.

Polecenie SQL SPOOL może zrzucić dane do zwykłego pliku, ale zwykle ma małą objętość. Natywne narzędzia, takie jak eksport lub pompa danych Oracle, są szybsze, ale wytwarzają zastrzeżone ekstrakty, które można ponownie zaimportować tylko do tej samej bazy danych i nie można ich analizować tak, jak zrobiłby to zwykły plik.

Jeśli chcesz szybko wyładować duże tabele do przenośnych plików płaskich, rozważ IRI FACT (Fast Extract) dla Oracle, DB2, Sybase, MySQL, SQL Server, Altibase, Tibero itp. FACT wykorzystuje równoległość i natywne protokoły połączeń z bazami danych (takie jak Oracle OCI ), aby zoptymalizować wydajność ekstrakcji. Darmowy FACT GUI (kreator), który jest częścią IRI Workbench, zbudowany na Eclipse™, prezentuje dostępne tabele i kolumny do wyodrębnienia i używa składni SQL SELECT.

Kolejną korzyścią płynącą z używania FACT jest integracja metadanych z programem SortCL w IRI Voracity w celu przekształcania, ochrony, ukierunkowania, a nawet raportowania fragmentów plików płaskich. FACT tworzy również plik kontrolny narzędzia do zbiorczego ładowania bazy danych w oczekiwaniu na ponowne zapełnianie tej samej tabeli przy użyciu wstępnie posortowanych płaskich plików w dużych operacjach ETL lub reorg.