W tym samouczku Big data Hadoop , przedstawimy szczegółowy opis bloku danych Hadoop HDFS. Przede wszystkim omówimy, czym jest blok danych w Hadoop, jakie jest ich znaczenie, dlaczego rozmiar bloków danych HDFS wynosi 128 MB.

Omówimy również przykład bloków danych w hadoop i różne zalety HDFS w Hadoop.

Wprowadzenie do bloku danych HDFS

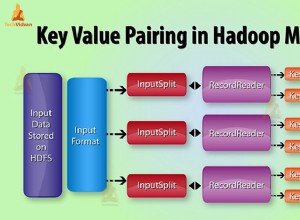

Hadoop HDFS dziel duże pliki na małe porcje, znane jako Bloki . Blok to fizyczna reprezentacja danych. Zawiera minimalną ilość danych, które można odczytać lub zapisać. HDFS przechowuje każdy plik jako bloki. Klient HDFS nie ma żadnej kontroli nad blokiem, takim jak lokalizacja bloku, Namenode decyduje o wszystkich takich rzeczach.

Domyślnie rozmiar bloku HDFS to 128 MB które możesz zmienić zgodnie z wymaganiami. Wszystkie bloki HDFS mają ten sam rozmiar, z wyjątkiem ostatniego bloku, który może mieć ten sam lub mniejszy rozmiar.

Struktura Hadoop dzieli pliki na bloki 128 MB, a następnie zapisuje je w systemie plików Hadoop. Aplikacja Apache Hadoop jest odpowiedzialna za dystrybucję bloku danych na wiele węzłów.

Przykład-

Załóżmy, że rozmiar pliku wynosi 513 MB, a my używamy domyślnej konfiguracji rozmiaru bloku 128 MB. Następnie platforma Hadoop utworzy 5 bloków, pierwsze cztery bloki 128 MB, ale ostatni blok będzie miał tylko 1 MB.

Stąd z przykładu jasno wynika, że nie jest konieczne, aby w HDFS każdy przechowywany plik był dokładną wielokrotnością skonfigurowanego rozmiaru bloku 128 MB, 256 MB itd. Dlatego końcowy blok dla pliku zajmuje tylko tyle miejsca, ile jest potrzebne.

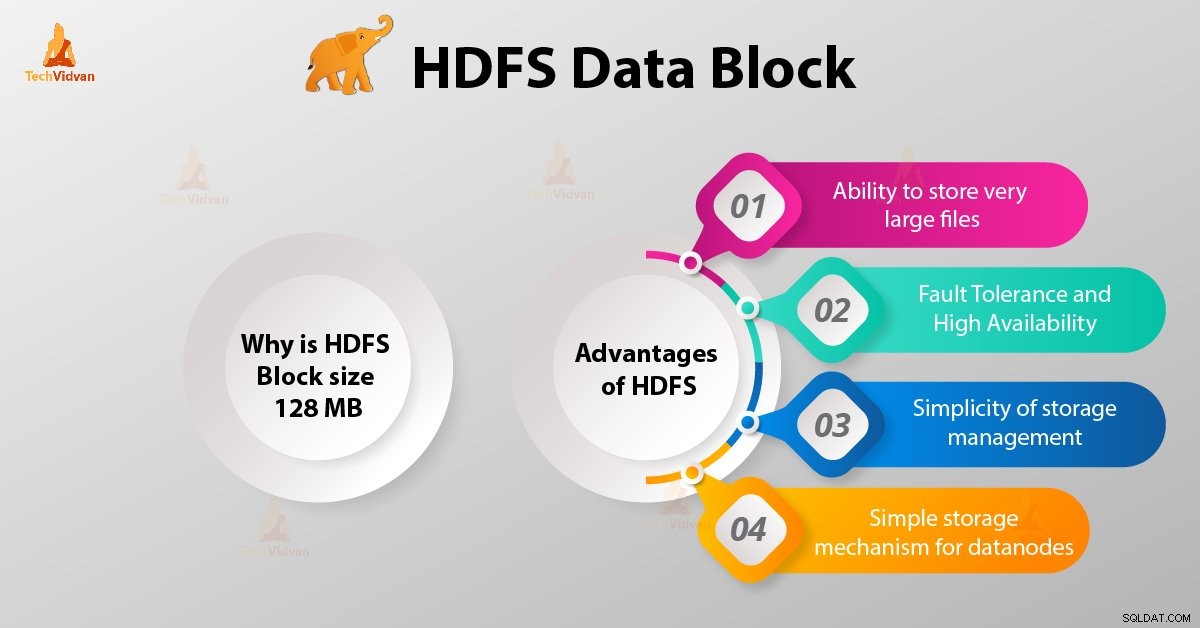

Dlaczego blok HDFS ma rozmiar 128 MB?

HDFS przechowuje terabajty i petabajty danych. Jeśli rozmiar bloku HDFS wynosi 4kb, jak w systemie plików Linux, będziemy mieli za dużo bloków danych w Hadoop HDFS, a więc za dużo metadanych.

Tak więc utrzymywanie i zarządzanie tą ogromną liczbą bloków i metadanych spowoduje ogromne obciążenie i ruch, czego nie chcemy.

Rozmiar bloku nie może być tak duży, aby system czekał bardzo długo na zakończenie pracy ostatniej jednostki przetwarzania danych.

Zalety HDFS

Po nauczeniu się, czym jest blok danych HDFS, omówmy teraz zalety Hadoop HDFS.

1. Możliwość przechowywania bardzo dużych plików

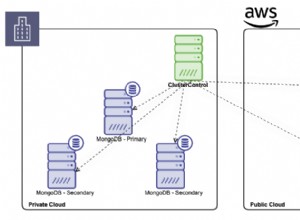

Hadoop HDFS przechowuje bardzo duże pliki, które są nawet większe niż rozmiar pojedynczego dysku, ponieważ struktura Hadoop dzieli plik na bloki i dystrybuuje je w różnych węzłach.

2. Odporność na awarie i wysoka dostępność HDFS

Platforma Hadoop może łatwo replikować bloki między węzłami danych. W ten sposób zapewnij odporność na awarie i wysoką dostępność HDFS.

3. Prostota zarządzania pamięcią masową

Ponieważ HDFS ma stały rozmiar bloku (128 MB), bardzo łatwo jest obliczyć liczbę bloków, które można przechowywać na dysku.

4. Prosty mechanizm przechowywania danych dla węzłów danych

Blokowanie w HDFS upraszcza przechowywanie Datanodów . Nazwa węzła przechowuje metadane wszystkich bloków. HDFS Datanode nie musi martwić się o metadane bloków, takie jak uprawnienia do plików itp.

Wniosek

Dlatego blok danych HDFS jest najmniejszą jednostką danych w systemie plików. Domyślny rozmiar bloku HDFS to 128 MB, który można skonfigurować zgodnie z wymaganiami. Bloki HDFS można łatwo replikować między węzłami danych. Dlatego zapewnij odporność na błędy i wysoką dostępność HDFS.

W przypadku jakichkolwiek zapytań lub sugestii związanych z blokami danych Hadoop HDFS daj nam znać, zostawiając komentarz w sekcji podanej poniżej.